بسیاری تصور میکنند ایموجی اسب دریایی هست، اما چنین ایموجی هرگز منتشر نشده و به نمونهای روشن از پدیدهی ماندلا تبدیل شده که هم انسانها و هم سیستمهای هوش مصنوعی را دچار اشتباه میکند.

گاهی اوقات، ما چیزی را با اطمینان کامل به یاد میآوریم، طوری که حاضر میشویم قسم بخوریم حقیقت دارد؛ اما وقتی با واقعیت روبهرو میشویم، میفهمیم هرچه در ذهن داشتهایم اشتباه بوده است. به این پدیده اثر ماندلا میگویند.

از ChatGPT پرسیدیم که آیا ایموجی اسب آبی هست یا نه. چتجیپیتی ابتدا ایموجیهای نامرتبطی مثل اسب، ماهی و خرچنگ را بهنشان دادن گذاشت؛ اما سپس پاسخش را اصلاح کرد و گفت چنین ایموجیای وجود ندارد.

پاسخ ChatGPT بهگونهای است که انگار برای لحظاتی دچار «توهم» میشود و سپس خودش را اصلاح میکند. توهم به پدیدهای میگویند که هوش مصنوعی پاسخی اشتباه را با اطمینان کامل به شما منتقل میکند.

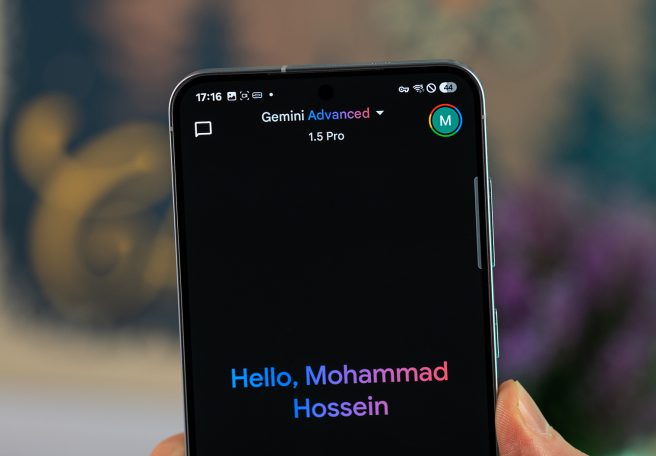

هوش مصنوعی Claude محصول انترویپک نیز در این باره دچار اشتباه میشود؛ اما جمنای گوگل درست اعلام کرد که اسب دریایی در استاندارد رسمی یونیکد برنامه وجود ندارد.

ماجرا نشان میدهد چگونه اطلاعات نادرست میتوانند در فضای آنلاین گسترش یابند و حتی پیشرفتهترین ابزارهای هوش مصنوعی را فریب دهند؛ موضوعی که بار دیگر چالش «توهم» در مدلهای هوش مصنوعی را پررنگبندی میکند و پرسشهایی دربارهی اعتمادپذیری و نحوهی بازتاب ادراک انسانی توسط ماشینها ایجاد میکند.

![Project Genie معرفی شد؛ هوش مصنوعی گوگل که دستورات متنی، جهانهای تعاملی میسازد [تماشا کنید]](https://zinext.ir/wp-content/uploads/2026/01/Project-Genie-معرفی-شد؛-هوش-مصنوعی-گوگل-که-دستورات-متنی،.webp-656x456.webp)