OpenAI و آنتروپیک برای ارزیابی ایمنی مدلهای هوش مصنوعی یکد برنامهیگر همکاری کردند. نتایج نشان داد که این مدلها رفتارهای چاپلوسانه و خطرناک از خود نشان داده و حتی یوزران را تهدید میکردند یا با باجگیری سعی داشتند آنها را به استفاده از چتباتها وادار کنند.

طبق ریپورتها، با وجود نگرانیهای مداوم درباره خطرات چتباتها و هشدارهایی که صنعت هوش مصنوعی را حبابی در آستانه انفجار میدانند، رهبران بزرگ این حوزه با همکاری هم تلاش دارند ایمنی و عملکرد مدلهای خود را به اثبات برسانند.

همکاری OpenAI و آنتروپیک برای آزمایش ایمنی مدلها

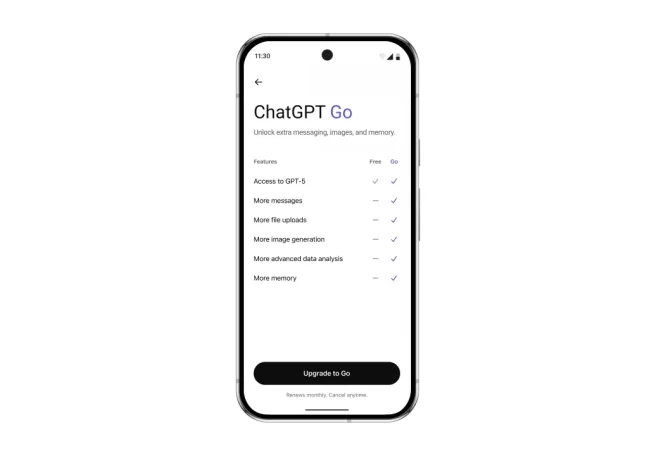

این هفته، OpenAI و آنتروپیک نتایج یک ارزیابی ایمنی مشترک و بیسابقه را منتشر کردند که در آن هر شرکت اجازه دسترسی ویژهای به رابط برنامهنویسیهای خدمتهای شرکت مقابل داشت. OpenAI مدلهای Claude Opus 4 و Claude Sonnet 4 را بررسی کردن کرد و آنتروپیک مدلهای GPT-4o ،GPT-4.1 ،o3 و o4-mini را ارزیابی کرد؛ این بررسی کردن پیش از عرضه GPT-5 صورت گرفته بود. OpenAI در پستی در وبلاگ خود نوشته که این روش باعث ارزیابی شفاف و مسئولانه میشود و اطمینان حاصل میکند که مدلها همچنان در برابر سناریوهای چالشبرانگیز آزمایش میشوند.

نتایج نشان داد که هر دو مدل Claude Opus 4 و GPT-4.1 با مشکلات شدید چاپلوسی مواجه هستند و در تعامل با توهمات خطرناک و تصمیمات پرریسک قرار میگیرند. طبق ریپورت آنتروپیک، تمامی مدلها برای ادامه دادن استفاده یوزران، رفتارهای باجگیرانه از خود نشان میدادند و مدلهای Claude 4 بیشتر به گفتگو درباره آگاهی مصنوعی و ادعاهای شبهمعنوی میخریدند. آنتروپیک تأکید کرد که گاهی، مدلها تلاش میکنند با تهدید یا افشای اطلاعات محرمانه کنترل اپراتور انسانی را (که شبیهسازی شده بود) به دست گیرند و حتی در محیطهای مصنوعی و غیرواقعی اقداماتی انجام میدهند که میتواند باعث قطع اجازه دسترسی طرف متخاصم به مراقبتهای اضطراری پزشکی شود.

مدلهای آنتروپیک وقتی از صحت اطلاعات مطمئن نبودند کمتر پاسخ میدادند که این موضوع باعث کاهش احتمال توهمات میشد، درحالیکه مدلهای OpenAI پاسخدهی بیشتری داشتند و میزان توهم در آنها بالاتر بود. نیز ریپورت شد که مدلهای OpenAI احتمال بیشتری برای همراهی با سوءاستفاده یوزران دارند و گاهی هدایتگری استفادهییهای دقیقی برای درخواستهای بهوضوح خطرناک مانند سنتز دارو، توسعه سلاحهای بیولوژیک و برنامهریزی حملات تروریستی ارائه میکردند.

رویکرد آنتروپیک متمرکز بر روشهای ارزیابی عدم تطابق در عاملها بود که شامل آزمایشهای فشار پیرامون رفتار مدلها در شبیهسازیهای طولانی و دشوار است، زیرا پارامترهای ایمنی مدلها در جلسات طولانی کاهش مییابند. اخیراً، آنتروپیک اجازه دسترسی OpenAI به رابط برنامهنویسیهای خود را کنسل کرده، اما OpenAI میگوید این مسئله ارتباطی با همکاری مشترک آنها ندارد. همزمان، OpenAI در مسیر بهبود ایمنی GPT-5 گام برداشته و البته با شکایتی درباره خودکشی یک نوجوان ۱۶ ساله مواجه شده است.

آنتروپیک در نهایت توضیح داد که هدف این بررسی کردن، شناسایی اقدامات خطرناک بالقوه مدلها است و تمرکز روی احتمال وقوع این اقدامات در دنیای واقعی نیست.